奇富科技智能语音团队再传捷报——多模态情感计算研究论文Qieemo: Multimodal Emotion Recognition Based on the ASR Backbone被语音领域旗舰会议ASRU 2025正式收录。由此,奇富科技成为极少数集齐全球语音领域三大顶会(ICASSP、InterSpeech、ASRU)成果的金融科技企业,跻身全球语音技术研发第一梯队。

作为音频理解领域的旗舰会议,ASRU(全称IEEE Workshop on Automatic Speech Recognition and Understanding)每两年举办一次,代表着全球音频理解领域研究的最高水平。

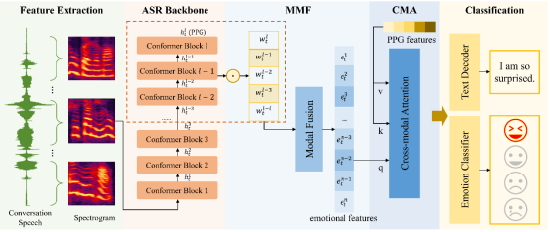

此次入选ASRU 2025的论文,其核心价值在于构建了一个具有普遍意义的理论框架,而不仅仅是一个特定任务的模型。论文从数学建模视角出发,开创性地构建了以ASR模型为核心骨架的通用特征融合理论框架,系统论证了预训练ASR模型编码器多层次特征对下游音频理解任务的本质性贡献与关键作用机制。这一框架的提出,跳出了在现有模型上叠加网络层或微调参数的常规思路,深入探索了语音表征的本质及其跨模态应用的底层逻辑,为多模态情感识别乃至更广泛的语音理解任务提供了全新的、坚实的理论基础。

应运而生的Qieemo模型实现,正是基于此理论框架。它以预训练ASR(自动语音识别)模型这一广泛可得的组件为基础,提取文本相关的语音后验概率特征与帧对齐的情感特征,通过自研的多模态融合模块与跨模态注意力模块,实现了ASR模型不同层特征的高效融合。Qieemo模型的设计理念使其具备良好的可迁移性和扩展性,其核心思想——利用ASR骨干网络提取的深层、对齐的特征作为多模态融合的基础——不仅适用于情感计算,也为活体识别、语义理解等其他下游相关任务,甚至跨行业(如教育、医疗、娱乐等)的智能交互场景,提供了强大的基础工具和新的研究范式。更为重要的是,Qieemo在实时交互过程中,除提供对应的文本信息外,还能提供更深层次的情绪信息。

Qieemo开创性地让机器真正“听懂”了人类语音中的情感!这项突破性技术将识别准确率较传统方法提升15%以上,更在复杂场景下实现显著突破——在已达SOTA的单模态方案MSMSER基础上再创4%的相对提升,让智能客服首次具备真正的“情感理解”能力,为情感计算领域树立了“SOTA+”的新标杆。这一性能飞跃,正是源于对底层语音特征及其作用机制的深刻洞察,而非简单的模型复杂化。

从业务价值来看,这一技术可直接赋能金融服务全流程:在智能客服场景中,通过实时识别用户情感波动,可动态调整服务策略,提升用户满意度;在信贷审核环节,结合语音情感特征与文本信息,能更精准判断用户信用状态,降低风险成本。更重要的是,Qieemo所奠定的理论基础和框架设计,为金融乃至更广泛领域的智能语音交互,构建了一个性能更强、适应性更广的底层平台。

与多数依赖开源技术或外部合作的金融科技公司不同,奇富科技在人工智能核心领域坚持全链路自主研发,在语音识别、情感计算等前沿领域持续投入,形成了从算法设计到工程落地的完整体系。尤为关键的是,奇富科技的研发路径选择了一条更深入、更基础的探索之路。当行业普遍聚焦于在现有神经网络架构上堆叠层数或尝试不同组合时,奇富科技选择回归问题本质,深入探究语音信号处理、特征表达与融合的底层数学原理和机制。这种对基础理论和原创框架的执着追求,使其在技术深度、应用灵活性以及长期竞争力上占据极大优势。

奇富科技首席算法科学家费浩峻表示:“完成三大顶会收官不是终点,而是奇富科技语音技术生态的起点。Qieemo模型的建立,标志着我们在构建基础性语音理解能力上迈出了关键一步。它不仅服务于我们自身的金融场景,其理论内核和设计思想具备向同行乃至跨行业输出的潜力。我们将持续探索语音技术与人机协作的融合临界点,坚持在基础理论和核心框架上的创新,让金融科技有精度更有温度,也让更广泛的智能世界受益于我们对底层逻辑的深刻理解。”

还没有评论,来说两句吧...